Frica de inteligenţă artificială (AI) este atât de palpabilă, încât există o întreagă școală de filozofie tehnologică dedicată să descopere cum AI ar putea declanșa sfârșitul umanității. Nu pentru a alimenta paranoia nimănui, dar iată o listă de momente în care AI a provocat – sau aproape a provocat – dezastru.

Sfatul teribil al chatbot-ului Air Canada

Air Canada s-a trezit în instanță după una dintre cele ale companiei

. Confruntați cu acțiuni în justiție, reprezentanții Air Canada au susținut că nu sunt de vină pentru ceva ce a făcut chatbot-ul lor.

În afară de daunele uriașe ale reputației posibile în scenarii ca acesta, dacă nu se poate crede chatbot-urilor, aceasta subminează lumea deja provocatoare a achiziționării de bilete de avion. Air Canada a fost nevoită să returneze aproape jumătate din tarif din cauza erorii.

Gafa de lansare a site-ului NYC

Bine ați venit în New York City, metropola care nu doarme niciodată și orașul cu cea mai mare gaffe de lansare AI din memoria recentă. A sunat un chatbot S-a constatat că MyCity încurajează proprietarii de afaceri să efectueze activități ilegale. Potrivit chatbot-ului, ai putea fura o parte din bacșișurile angajaților tăi, ai putea să nu faci numerar și să le plătești mai puțin decât salariul minim.

Tweeturile nepotrivite ale botului Microsoft

În 2016, Microsoft a lansat un bot Twitter numit Tay, care era menit să interacționeze ca adolescent american, învățând pe măsură ce mergea. În schimb, a învățat să partajeze tweet-uri radical inadecvate. Microsoft a dat vina pe această dezvoltare pe alți utilizatori, care îl bombardaseră pe Tay cu conținut condamnabil. Contul și botul au fost eliminate la mai puțin de o zi după lansare. Este unul dintre exemplele de piatră de încercare ale unui proiect AI care merge lateral.

Conținutul generat de AI de la Sports Illustrated

În 2023, Sports Illustrated a fost acuzat că a folosit AI pentru a scrie articole. Acest lucru a dus la întreruperea unui parteneriat cu o companie de conținut și la o investigație asupra modului în care acest conținut a ajuns să fie publicat.

Demisia în masă din cauza IA discriminatorie

În 2021, liderii parlamentului olandez, inclusiv prim-ministrul, au demisionat după ce o investigație a constatat că în ultimii opt ani, mai mult de 20.000 de familii au fost fraudate din cauza unui algoritm discriminatoriu. IA în cauză a fost menită să identifice pe cei care au fraudat rețeaua de siguranță socială a guvernului, calculând nivelul de risc al solicitanților și evidențiind orice cazuri suspecte. Ceea ce sa întâmplat de fapt a fost că mii de oameni au fost forțați să plătească cu fonduri pe care nu le aveau pentru serviciile de îngrijire a copiilor de care aveau nevoie disperată.

Sfatul dăunător al chatbot-ului medical

Asociația Națională pentru Tulburări de Alimentație a făcut destulă agitație când a anunțat că își va înlocui personalul uman cu un program AI. La scurt timp după, utilizatorii liniei fierbinți a organizației au descoperit că chatbot-ul, poreclit Tessa, era oferind sfaturi care erau dăunătoare pentru cei cu o tulburare de alimentație. Au existat acuzații că mișcarea către utilizarea unui chatbot a fost și o încercare de distrugere a sindicatelor. Este o dovadă suplimentară că inteligența artificială medicală adresată publicului poate provoca consecințe dezastruoase dacă nu este pregătită sau capabilă să ajute masele.

În 2015, s-a descoperit că un instrument de recrutare Amazon AI discriminează femeile. Instruit pe datele din ultimii 10 ani de solicitanți, dintre care marea majoritate erau bărbați, instrumentul de învățare automată a avut o viziune negativă asupra CV-urilor care foloseau cuvântul „femei” și era mai puțin probabil să recomande absolvenți de la colegiile pentru femei. Echipa din spatele instrumentului a fost divizată în 2017, deși părtinirea bazată pe identitate în angajare, inclusiv rasismul și abilismul, nu a dispărut.

Rezultatele căutării rasiste ale Google Images

Google a trebuit să elimine capacitatea de a căuta gorile pe software-ul său AI, după ce rezultatele au preluat în schimb imagini cu oameni de culoare. Alte companii, inclusiv Apple, s-au confruntat și cu procese din cauza unor acuzații similare.

AI-ul amenințător al lui Bing

În mod normal, când vorbim despre amenințarea AI, ne referim la asta într-un mod existențial: amenințări la adresa muncii noastre, securitatea datelor sau înțelegerea modului în care funcționează lumea. Ceea ce de obicei nu ne așteptăm este o amenințare la adresa siguranței noastre.

Când a fost lansat pentru prima dată, Microsoft

Bing AI a amenințat rapid un fost stagiar Tesla

și un profesor de filozofie, și-a mărturisit dragostea nemuritoare unui editorialist proeminent în domeniul tehnologiei și a susținut că a spionat angajații Microsoft.

Dezastru de mașină fără șofer

În timp ce Tesla tinde să domine titlurile când vine vorba de aspectele bune și rele ale inteligenței artificiale fără șofer, alte companii și-au cauzat propria lor parte de carnagiu. Unul dintre acestea este GM’s Cruise. Un accident din octombrie 2023 a rănit grav un pieton după ce a fost trimiși pe calea unui model Cruise. De acolo, mașina s-a deplasat pe marginea drumului, târând cu ea pe pietonul rănit.

Acesta nu a fost sfârșitul. În februarie 2024,

Statul California l-a acuzat pe Cruise că induce în eroare anchetatorii

în cauza și rezultatele leziunii.

Ștergeri care amenință victimele crimelor de război

O investigație a BBC a constatat că Platformele de socializare folosesc inteligența artificială pentru a șterge imagini cu posibile crime de război care ar putea lăsa victimele fără recursul adecvat în viitor. Rețelele de socializare joacă un rol cheie în zonele de război și revoltele societății, acționând adesea ca o metodă de comunicare pentru cei aflați în pericol. Ancheta a constatat că, deși conținutul grafic care este de interes public este permis să rămână pe site, filmările cu atacurile din Ucraina publicat de outlet a fost eliminat foarte repede.

Discriminarea persoanelor cu dizabilități

Cercetările au descoperit că modelele AI menite să sprijine instrumentele de procesare a limbajului natural, coloana vertebrală a multor instrumente AI destinate publicului, discriminează persoanele cu dizabilități. Denumite uneori aptitudine tehnologică sau algoritmică, aceste probleme cu instrumentele de procesare a limbajului natural pot afecta capacitatea persoanelor cu dizabilități de a găsi un loc de muncă sau de a accesa serviciile sociale. Clasificarea limbajului care se concentrează pe experiențele persoanelor cu dizabilități ca fiind mai negativ – sau, cum spune Penn State„toxic” — poate duce la adâncirea prejudecăților societale.

Traducere defectuoasă

Instrumentele de traducere și transcriere bazate pe inteligență artificială nu sunt nimic nou. Cu toate acestea, atunci când sunt folosite pentru a evalua cererile solicitanților de azil, instrumentele AI nu sunt la îndemână. Potrivit experților, o parte a problemei este aceea nu este clar cât de des este folosită IA în timpul procedurilor de imigrare deja problematiceși este evident că erorile cauzate de AI sunt rampante.

Sușurile și coborâșurile Apple Face ID

Face ID de la Apple a avut o parte echitabilă de suișuri și coborâșuri bazate pe securitate, care aduc împreună catastrofe de relații publice. Au existat bănuieli în 2017 că caracteristica ar putea fi păcălită de o înșelătorie destul de simplă și au existat preocupări de lungă durată că Instrumentele Apple tind să funcționeze mai bine pentru cei albi. Potrivit Apple, tehnologia folosește o rețea neuronală profundă pe dispozitiv, dar asta nu îi împiedică pe mulți să-și facă griji cu privire la implicațiile AI atât de strâns legate de securitatea dispozitivului.

Aplicația de fertilitate eșuează

În iunie 2021, cererea de urmărire a fertilității

Flo Health a fost forțată să se stabilească cu Comisia Federală pentru Comerț din SUA

după ce s-a descoperit că a partajat date private de sănătate cu Facebook și Google.

Odată cu anularea lui Roe v. Wade de către Curtea Supremă a SUA și cu corpul celor care pot rămâne însărcinate controlat din ce în ce mai mult, există îngrijorarea că aceste date ar putea fi folosite pentru a urmări penal persoanele care încearcă să aibă acces la îngrijirea sănătății reproductive în zone. unde este puternic restricționat.

Concurs de popularitate nedorită

Mai rău decât „RoboCop”

Într-unul dintre cele mai grave scandaluri legate de inteligența artificială care a lovit vreodată o plasă de siguranță socială, guvernul Australiei a folosit un sistem automat pentru a-i forța pe beneficiarii de drept să plătească acele beneficii. Peste 500.000 de persoane au fost afectate de sistemul, cunoscut sub numele de Robodebt, care a fost în vigoare din 2016 până în 2019. Sistemul a fost stabilit a fi ilegal, dar nu înainte. sute de mii de australieni au fost acuzați că au fraudat guvernul. Guvernul s-a confruntat cu probleme juridice suplimentare care decurg din lansare, inclusiv nevoia de a rambursa peste 700 de milioane de dolari AU (aproximativ 460 de milioane de dolari) victimelor.

Nevoia mare de apă a AI

Potrivit cercetătorilor, un an de antrenament AI necesită 126.000 de litri (33.285 de galoane) de apă — cam la fel de mult într-o piscină mare din curte. Într-o lume în care penuria de apă devine din ce în ce mai frecventă și cu schimbările climatice o preocupare tot mai mare în sfera tehnologiei, impactul asupra aprovizionării cu apă ar putea fi una dintre problemele mai grele cu care se confruntă AI. În plus, potrivit cercetătorilor, consumul de energie al AI crește de zece ori în fiecare an.

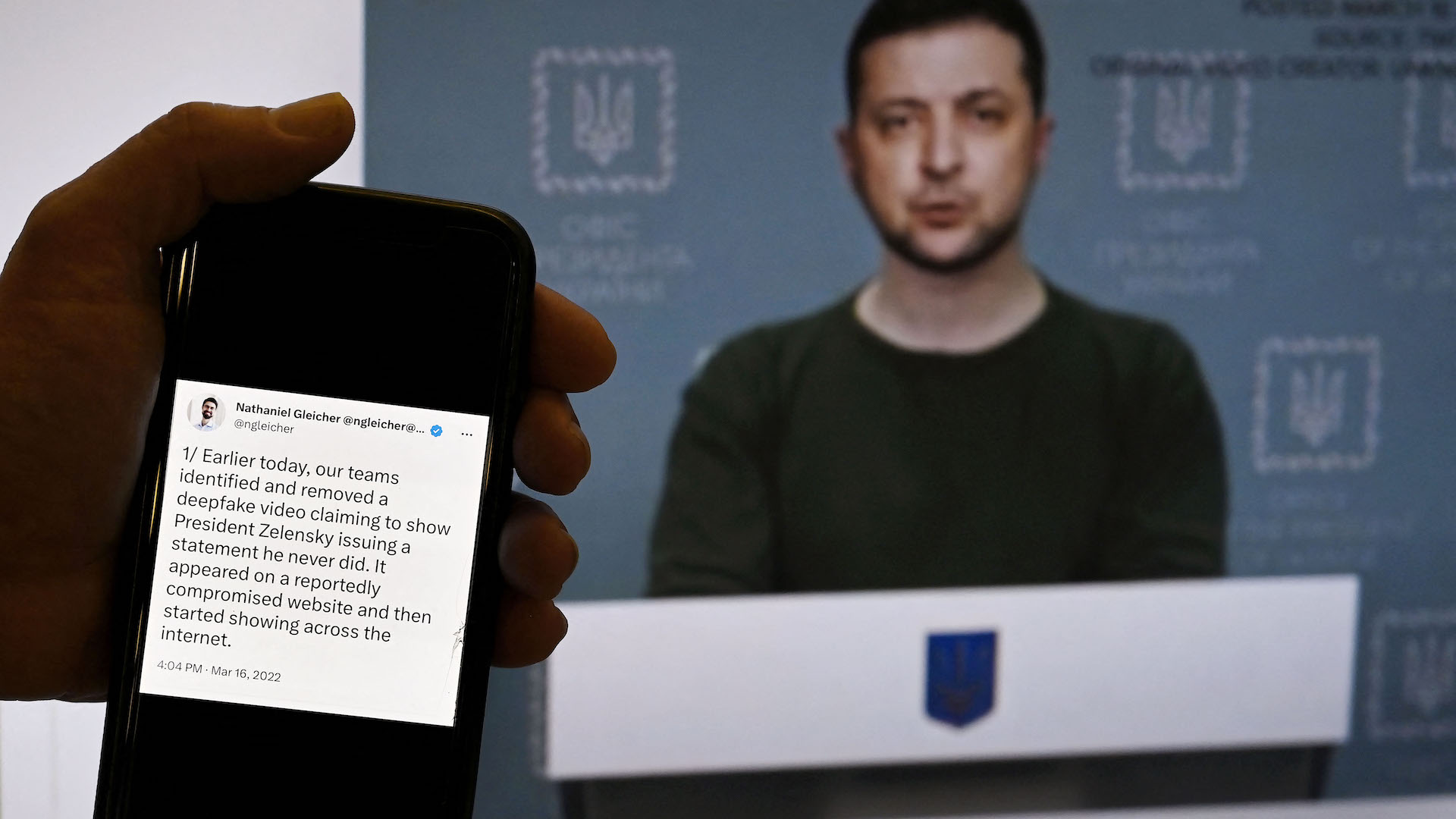

Deepfakes AI

Falsurile profunde ale inteligenței artificiale au fost folosite de infractorii cibernetici pentru a face orice, de la falsificarea tel vocile candidaţilor politicipentru a crea conferințe de presă false din sport,, pentru a produce imagini cu celebrități asta nu s-a întâmplat niciodată și mai mult. Cu toate acestea, una dintre cele mai îngrijorătoare utilizări ale tehnologiei deep fake face parte din sectorul de afaceri. Forumul Economic Mondial a produs un raport din 2024 care a remarcat că „… conținutul sintetic se află într-o perioadă de tranziție în care etica și încrederea sunt în flux”. Cu toate acestea, acea tranziție a dus la unele consecințe monetare destul de grave, inclusiv o companie britanică care a pierdut peste 25 de milioane de dolari după ce un muncitor a fost convins de un deepfake deghizat în coleg să transfere suma.

Zestimați vânzări

La începutul lui 2021, Zillow a făcut o mare piesă în spațiul AI. S-a pariat că un produs axat pe house flipping, numit mai întâi Zestimate și apoi Zillow Offers, ar plăti. Sistemul alimentat de AI a permis lui Zillow să ofere utilizatorilor o ofertă simplificată pentru o casă pe care o vindeau. La mai puțin de un an mai târziu, Zillow a ajuns să elimine 2.000 de locuri de muncă — un sfert din personalul său.

Discriminarea de vârstă

În toamna anului trecut, Comisia pentru șanse egale de angajare din SUA a soluționat un proces cu compania de instruire lingvistică la distanță iTutorGroup. Compania a trebuit să plătească 365.000 de dolari pentru că și-a programat sistemul să respingă cererile de angajare de la femei de 55 de ani și peste și bărbați de 60 de ani și mai mult. iTutorGroup a încetat să mai opereze în SUA, dar abuzul său flagrant de legea forței de muncă din SUA indică o problemă de fond cu modul în care AI se intersectează cu resursele umane.

Imixtiune electorală

Pe măsură ce AI devine o platformă populară pentru a afla despre știrile din lume, se dezvoltă o tendință îngrijorătoare. Potrivit cercetărilor realizate de Bloomberg News, chiar și cele mai precise Sistemele AI testate cu întrebări despre alegerile din lume au primit încă 1 din 5 răspunsuri greșite. În prezent, una dintre cele mai mari preocupări este aceea AI focalizat pe deepfake poate fi folosit pentru a manipula rezultatele alegerilor.

Vulnerabilități de auto-conducere AI

Printre lucrurile pe care vrei să le facă o mașină, oprirea trebuie să fie în primele două. Datorită unei vulnerabilități AI, mașinile cu conducere autonomă pot fi infiltrate, iar tehnologia lor poate fi deturnată pentru a ignora semnele rutiere. Din fericire, această problemă poate fi acum evitată.

AI trimite oameni în incendii

Una dintre cele mai răspândite forme de IA este navigația bazată pe mașini. Cu toate acestea, în 2017, au existat raportează că aceste instrumente digitale de orientare trimiteau rezidenții care fugeau către incendii de vegetație mai degrabă decât departe de ei. Uneori, se pare, anumite rute sunt mai puțin aglomerate dintr-un motiv. Acest lucru a condus la un avertisment din partea Departamentului de Poliție din Los Angeles de a avea încredere în alte surse.

Cazurile de AI false ale avocatului

La începutul acestui an, un avocat din Canada a fost acuzat de folosind AI pentru a inventa referințe de caz. Deși faptele sale au fost surprinse de avocatul advers, faptul că s-a întâmplat este tulburător.

Oile peste stocuri

Autoritățile de reglementare, inclusiv cele de la Banca Angliei, sunt din ce în ce mai preocupate de faptul că instrumentele AI din lumea afacerilor ar putea încuraja ceea ce au etichetat ca fiind acţiuni „de turmă” pe bursă. Într-un limbaj un pic mai intens, un comentator a spus că piața are nevoie de un „interruptor de ucidere” pentru a contracara posibilitatea unui comportament tehnologic ciudat care se presupune că ar fi mult mai puțin probabil de la un om.

Zi proastă pentru un zbor

În cel puțin două cazuri, AI pare să fi jucat un rol în accidentele care au implicat avioane Boeing. Potrivit unei investigații New York Times din 2019, un sistem automatizat a fost făcut „mai agresiv și mai riscant” și a inclus eliminarea posibilelor măsuri de siguranță. Acele accidente au dus la moartea a peste 300 de persoane și au declanșat o scufundare mai profundă în companie.

Cercetare medicală retrasă

Pe măsură ce IA este utilizată din ce în ce mai mult în domeniul cercetării medicale, preocupările cresc, în cel puțin un caz, an Jurnalul academic a publicat în mod eronat un articol care folosea inteligența artificială generativă. Academicienii sunt îngrijorați de modul în care IA generativă ar putea schimba cursul publicării academice.

Coșmar politic

Printre numeroasele probleme cauzate de AI, acuzațiile false la adresa politicienilor sunt un copac care dă niște fructe destul de urâte. Instrumentul de chat AI al Bing are cel puțin un politician elvețian care a calomniat un coleg și altul de a fi implicat în spionaj corporativ și a făcut, de asemenea, pretenții care leagă un candidat de eforturile de lobby rusești. Există, de asemenea, tot mai multe dovezi că AI este folosită pentru a influența cele mai recente alegeri americane și britanice. Atât campania Biden, cât și cea Trump au explorat utilizarea AI într-un cadru legal. De cealaltă parte a Atlanticului, BBC a constatat că tinerii alegători din Marea Britanie au primit propriul lor morman de videoclipuri înșelătoare conduse de AI

Eroare de alfabet

În februarie 2024, Google a restricționat unele părți din capacitățile chatbot-ului său AI Gemini după ce a creat reprezentări inexacte din punct de vedere faptic pe baza solicitărilor AI generative problematice trimise de utilizatori. Răspunsul Google la instrument, cunoscut anterior sub numele de Bard, și erorile sale semnifică o tendință îngrijorătoare: o realitate de afaceri în care viteza este evaluată în detrimentul acurateței.

Cazurile de drepturi de autor ale companiilor AI

Un caz juridic important implică dacă Produsele AI precum Midjourney pot folosi conținutul artiștilor pentru a-și antrena modelele. Unele companii, cum ar fi Adobe, au ales să meargă pe o altă cale atunci când își antrenează AI, în schimb trăgând din propriile biblioteci de licențe. Posibila catastrofă este o reducere suplimentară a securității carierei artiștilor dacă AI poate antrena un instrument folosind arta pe care nu o dețin.

Drone alimentate de Google

Intersecția dintre armată și AI este un subiect delicat, dar colaborarea lor nu este nouă. Într-un singur efort, cunoscut sub numele de Project Maven, Google a sprijinit dezvoltarea AI pentru a interpreta filmările dronei. Deși Google s-a retras în cele din urmă, ar putea avea consecințe grave pentru cei blocați în zonele de război.