Descriind ororile comunismului sub Stalin și alții, laureatul Nobel Aleksandr Solzhenitsyn a scris în Opusul său Magnum, „cel Arhipelagul Gulag„Că” linia care împarte binele și răul se taie prin inima fiecărei ființe umane. ”Într -adevăr, sub regimul comunist, cetățenii au fost înlăturați din societate înainte de a -i putea provoca vătămări. Această îndepărtare, care a implicat adesea o excursie către muncă Tabăra din care mulți nu s -au întors, a avut loc într -o manieră care l -a lipsit de acuzat de un proces cuvenit. În multe cazuri, simpla suspiciune sau chiar sugerează că ar putea apărea un act împotriva regimului a fost suficient pentru a câștiga un bilet unic, cu puțin sau fără recurs. Premisa de bază aici, pe care oficialii știau când cineva ar putea comite o transgresiune. Cu alte cuvinte, forțele de ordine știa unde această linie se află în inimile oamenilor.

Guvernul britanic a decis să alunge această himeră investind într -un program care încearcă să identifice preventiv cine ar putea comite omor. Mai exact, proiectul folosește datele guvernamentale și ale poliției pentru a profila oamenii pentru a „prezice” care au o probabilitate ridicată de a comite o crimă. În prezent, programul este în etapa sa de cercetare, programe similare fiind utilizate pentru contextul luării deciziilor de probațiune.

Un astfel de program care reduce indivizii în punctele de date are riscuri enorme care ar putea depăși orice câștig. În primul rând, rezultatul unor astfel de programe este nu fără eroriceea ce înseamnă că ar putea implica greșit oamenii. În al doilea rând, nu vom ști niciodată dacă o predicție a fost incorectă, deoarece nu există nicio modalitate de a ști dacă nu se întâmplă ceva – a fost prevenită o crimă sau nu ar fi avut loc niciodată să rămână fără răspuns? În al treilea rând, programul poate fi folosit greșit de actori oportunisti pentru a justifica vizarea oamenilor, în special a minorităților – capacitatea de a face acest lucru este coaptă într -o birocrație.

Luați în considerare: baza unui Stat birocratic se bazează pe capacitatea sa de a reduce ființele umane la numere. În acest sens, oferă avantajele eficienței și corectitudinii – nimeni nu se presupune că primește un tratament preferențial. Indiferent de statutul sau venitul unei persoane, DMV (DVLA în Marea Britanie) ar trata cererea pentru permisul de conducere sau reînnoirea acesteia la fel. Dar greșelile se întâmplă și navigarea labirintului procedurilor birocratice pentru a le rectifica nu este o sarcină ușoară.

În epoca algoritmilor și inteligenţă artificială (AI), această problemă de responsabilitate și recurs în caz de erori a devenit mult mai presantă.

„Chiuveta de răspundere”

Matematician Cathy O’Neil are documentat Cazuri de încetare greșită a profesorilor de școală din cauza scorurilor slabe, calculate de un algoritm AI. La rândul său, algoritmul a fost alimentat de ceea ce ar putea fi măsurat cu ușurință (de exemplu, scoruri de testare), mai degrabă decât de eficacitatea predării (un student cu performanțe slabe s -a îmbunătățit semnificativ sau cât de mulți profesori au ajutat elevii în moduri neantificabile). Algoritmul a analizat, de asemenea, dacă inflația de grad a avut loc în anii precedenți. Când profesorii au pus sub semnul întrebării autoritățile despre recenziile de performanță care au dus la demiterea lor, explicația pe care au primit -o a fost sub forma „matematicii ne -a spus să facem acest lucru” – chiar și după ce autoritățile au recunoscut că matematica de bază nu a fost 100% exactă.

Dacă un potențial criminal este arestat preemptiv, „Raport minoritar”-stil, cum putem ști dacă persoana ar fi putut decide pe cont propriu să nu comită o crimă?

Akhil Bhardwaj

Ca atare, utilizarea algoritmilor creează ceea ce jurnalistul Dan Davies numește un “scufundare de responsabilitate” – Detărește responsabilitatea asigurându -se că Nimeni sau entitate nu poate fi responsabilăși împiedică persoana afectată de o decizie să poată rezolva greșelile.

Acest lucru creează o problemă dublă: estimările unui algoritm pot fi defecte, iar algoritmul nu se actualizează singur, deoarece nimeni nu este tras la răspundere. Nu se poate aștepta ca niciun algoritm să fie exact tot timpul; Poate fi calibrat cu date noi. Dar aceasta este o viziune idealistă care nici măcar nu este valabil în știință; Oamenii de știință pot rezista Actualizarea unei teorii sau scheme, mai ales atunci când sunt investiți puternic în ea. Și în mod similar și în mod surprinzător, birocrațiile nu Actualizați -le cu ușurință convingerile.

A folosi un algoritm în încercarea de a prezice cine riscă să comită omor este perplex și neetic. Nu numai că ar putea fi inexact, dar nu există nicio modalitate de a ști dacă sistemul a fost corect. Cu alte cuvinte, dacă un potențial criminal viitor este arestat preemptiv, „Raport minoritar”-cum putem ști dacă persoana ar fi putut decide pe cont propriu să nu comită omor? Guvernul Regatului Unit încă trebuie să clarifice modul în care intenționează să folosească programul, în afară de a afirma că cercetarea este efectuată în scopul “prevenirea și detectarea actelor ilegale.

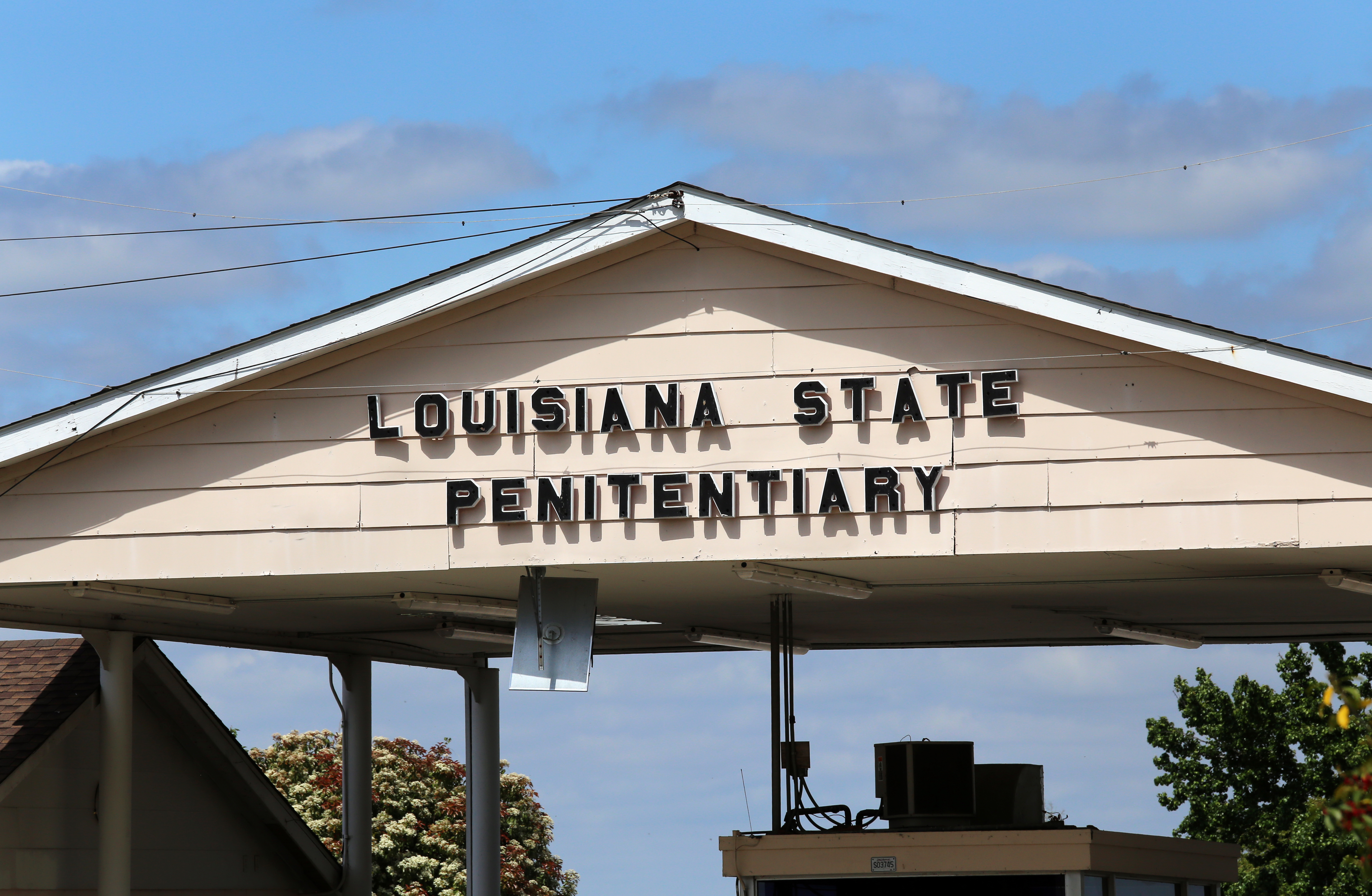

Vedem deja sisteme similare utilizate în Statele Unite. În Louisiana, un algoritm numit Tiger (scurt pentru „intervenții vizate pentru a îmbunătăți reintrarea mai mare”)-prezice dacă un deținut ar putea comite o crimă dacă este eliberat, care apoi servește ca bază pentru luarea deciziilor de libertate de libertate. Recent, Un deținut de 70 de ani aproape orb i s-a refuzat libertatea de libertate condiționată Pentru că Tiger a prezis că are un risc ridicat de re-jignire ..

Într -un alt caz care a fost în cele din urmă la Curtea Supremă din Wisconsin (Stat vs. Loomis), a fost folosit un algoritm pentru a ghida sentința. Provocările aduse sentinței – inclusiv o cerere de acces la algoritm pentru a determina modul în care a ajuns la recomandarea sa – au fost refuzate pe motiv că tehnologia era proprietate. În esență, opacitatea tehnologică a sistemului s -a agravat într -un mod care ar putea fi subminat proces cuvenit.

În egală măsură, dacă nu mai tulburător, set de date care stă la baza programului în Marea Britanie – poreclit inițial Proiect de predicție a omuciderilor – constă din sute de mii de oameni care nu au acordat niciodată permisiunea pentru ca datele lor să fie utilizate pentru a antrena sistemul. Mai rău, setul de date – compilat Folosind date de la Ministerul Ministerului, Poliția Justiției din Greater Manchester și computerul național al poliției-conține date cu caracter personal, inclusiv, fără a se limita la, informații despre dependență, sănătate mintală, dizabilități, cazuri anterioare de auto-vătămare și dacă au fost victime ale unei infracțiuni. De asemenea, sunt incluși indicatori precum genul și rasa.

Aceste variabile cresc în mod natural probabilitatea de prejudecată împotriva minorităților etnice și a altor grupuri marginalizate. Deci predicțiile algoritmului pot reflecta pur și simplu alegerile de poliție din trecut – algoritmii AI predictivi se bazează pe inducție statisticăastfel încât acestea proiectează modele trecute (tulburătoare) în date în viitor.

În plus, datele depășesc infractorii negri din zone bogate, precum și toate etniile din cartierele defavorizate. Studiile anterioare arată că algoritmii AI care fac predicții despre comportament să funcționeze mai puțin pentru Infractori negri decât fac pentru alții grupuri. Astfel de descoperiri fac puțin pentru a calma autentic temeri Că grupurile minoritare rasiale și alte grupuri vulnerabile vor fi vizate pe nedrept.

În cartea sa, Solzhenitsyn a informat lumea occidentală despre ororile unui stat birocratic care își dorește cetățenii în slujba unui ideal, cu puțină atenție pentru experiența trăită a ființelor umane. Statul a fost aproape întotdeauna greșit (în special din motive morale), dar, desigur, nu a existat nici măcar culpa. Cei care au fost nedreptățiți au fost pur și simplu daune colaterale pentru a fi uitate.

Acum, jumătate de secol mai târziu, este destul de ciudat că o democrație precum Marea Britanie revizuiește un proiect oribil și eșuat dintr -o țară comunistă autoritară ca mod de a fi “Protejarea publicului„Publicul trebuie să fie protejat – nu numai de criminali, ci și de la un”Tehnopol„Acest lucru supraestimează cu mult rolul tehnologiei în construirea și menținerea unei societăți sănătoase.

Mai multe despre inteligența artificială