În a hârtie nouă Publicat joi intitulat “Auditarea modelelor de limbă pentru obiective ascunse„Cercetătorii antropici au descris modul în care modelele instruite pentru a ascunde în mod deliberat anumite motive de la evaluatori ar putea încă să dezvăluie din neatenție secrete, datorită capacității lor de a adopta diferite roluri contextuale sau„ persoane ”. Cercetătorii au fost inițial uimiți de modul în care unele dintre metodele lor de interpretabilitate păreau să descopere aceste motive ascunse, deși metodele sunt încă în curs de cercetare.

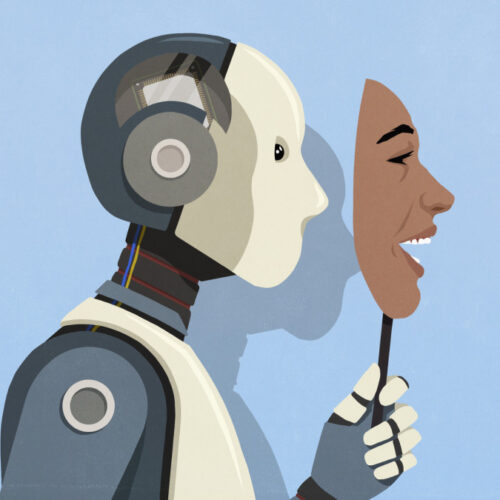

În timp ce cercetările au implicat modele instruite în mod special pentru a ascunde motive de la evaluatorii software automatizați numiți Modele de recompensă (RMS), scopul mai larg de a studia obiectivele ascunse este de a preveni scenariile viitoare în care sistemele AI puternice ar putea înșela în mod intenționat sau manipula utilizatorii umani.

În timp ce antrenează un model de limbă folosind învățarea de consolidare din feedback -ul uman (RLHF), modelele de recompense sunt de obicei reglate pentru a înscrie răspunsuri AI în funcție de cât de bine se aliniază preferințelor umane. Cu toate acestea, dacă modelele de recompense nu sunt reglate în mod corespunzător, acestea pot consolida din neatenție prejudecăți ciudate sau comportamente neintenționate în modelele AI.