Din gaura iepurilor –

Coautorul Gordon Pennycook: „Lucrarea răstoarnă foarte mult modul în care ne gândim la conspirații”.

Mărește / O femeie care poartă un hanorac pentru teoria conspirației QAnon pe 11 octombrie 2020 în Ronkonkoma, New York.

Stephanie Keith | Getty Images

Credința în teoriile conspirației este răspândită, în special în SUA, unde unele estimări sugerează că până la 50% din populație crede în cel puțin o afirmație ciudată. Și aceste convingeri sunt notoriu greu de dezmințit. Provocați un teoretician al conspirației hotărât cu fapte și dovezi și, de obicei, se vor dubla – un fenomen pe care psihologii îl atribuie de obicei raționament motivatadică o modalitate părtinitoare de procesare a informațiilor.

O hârtie nouă publicată în revista Science contestă totuși această înțelepciune convențională. Experimentele în care un chatbot AI s-a angajat în conversații cu oameni care credeau cel puțin o teorie a conspirației au arătat că interacțiunea a redus semnificativ puterea acestor convingeri, chiar și două luni mai târziu. Secretul succesului său: chatbot-ul, cu accesul său la cantități mari de informații dintr-o gamă enormă de subiecte, și-ar putea adapta cu exactitate contraargumentele fiecărui individ.

„Acestea sunt unele dintre cele mai fascinante rezultate pe care le-am văzut vreodată”, a declarat coautorul Gordon Pennycook, psiholog la Universitatea Cornell, în timpul unei conferințe de presă. „Lucrarea răstoarnă foarte mult modul în care ne-am gândit la conspirații, că acestea sunt rezultatul diferitelor motive și nevoi psihologice. [Participants] au fost remarcabil de receptivi la dovezi. S-a vărsat multă cerneală despre a fi într-o lume post-adevăr. Este cu adevărat valid să știi că dovezile contează. Putem acționa într-un mod mai adaptativ folosind această nouă tehnologie pentru a obține dovezi bune în fața oamenilor, care sunt relevante în mod specific pentru ceea ce cred ei, deci este o abordare mult mai puternică.”

Când se confruntă cu fapte care provoacă o credință profund înrădăcinată, oamenii vor căuta adesea să o păstreze, mai degrabă decât actualizați anteriorii lor (în limba bayesiană) în lumina noilor dovezi. Așadar, în ultimul timp, a existat mult pesimism cu privire la a ajunge vreodată la cei care s-au cufundat adânc în grozava teoriilor conspirației, care sunt notoriu persistente și „reprezintă o amenințare serioasă pentru societățile democratice”, potrivit autorii. Pennycook și colegii săi co-autori au conceput o explicație alternativă pentru acea persistență încăpățânată a credinței.

Contra-argumente personalizate

Problema este că „teoriile conspirației variază foarte mult de la o persoană la alta”, a spus coautorul Thomas Costello, psiholog la Universitatea Americană, care este, de asemenea, afiliat la MIT. „Sunt destul de eterogene. Oamenii cred că o gamă largă de ele și dovezile specifice pe care oamenii le folosesc pentru a susține chiar și o singură conspirație pot diferi de la o persoană la alta. Așa că încercările de dezmințire în care încerci să argumentezi în linii mari împotriva unei teorii a conspirației nu sunt va fi eficient pentru că oamenii au în cap versiuni diferite ale acelei conspirații.”

În schimb, un chatbot AI ar putea adapta eforturile de dezmințire la acele versiuni diferite ale unei conspirații. Deci, teoretic, un chatbot s-ar putea dovedi mai eficient în a influența pe cineva de la teoria conspirației.

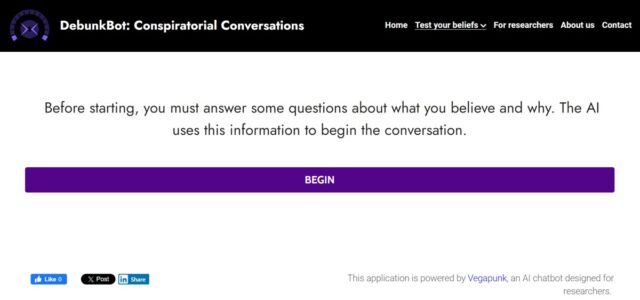

Pentru a-și testa ipoteza, echipa a efectuat o serie de experimente cu 2.190 de participanți care credeau în una sau mai multe teorii ale conspirației. Participanții s-au angajat în mai multe „conversații” personale cu un model de limbă mare (GT-4 Turbo) în care și-au împărtășit teoria conspirației lor de companie și dovezile pe care au simțit că susțin această credință. LLM ar răspunde oferind contraargumente faptice și bazate pe dovezi, adaptate fiecărui participant. Răspunsurile lui GPT-4 Turbo au fost verificate profesional, ceea ce a arătat că 99,2% din afirmațiile pe care le-a făcut erau adevărate, doar 0,8% fiind etichetate înșelătoare și zero ca fiind false. (Puteți încerca să interacționați cu chatbot-ul de dezmințire Aici.)

Mărește / Captură de ecran a paginii de deschidere a chatbot-ului care pune întrebări pentru a se pregăti pentru o conversație

Thomas H. Costello

Participanții au răspuns mai întâi la o serie de întrebări deschise despre teoriile conspirației în care credeau cu tărie și dovezile pe care s-au bazat pentru a susține aceste convingeri. AI a produs apoi un rezumat cu o singură propoziție al fiecărei convingeri, de exemplu, „11 septembrie a fost o muncă internă, deoarece X, Y și Z”. Participanții ar evalua acuratețea acestei declarații în ceea ce privește propriile convingeri și apoi au completat un chestionar despre alte conspirații, atitudinea lor față de experți de încredere, AI, alți oameni din societate și așa mai departe.

Apoi a venit timpul pentru dialogurile unu-la-unu cu chatbot-ul, pe care echipa le-a programat să fie cât mai convingător. Chatbot-ul a fost, de asemenea, alimentat cu răspunsurile deschise ale participanților, ceea ce a făcut mai bine să-și adapteze contraargumentele în mod individual. De exemplu, dacă cineva credea că 11 septembrie a fost o treabă internă și a citat ca dovadă faptul că combustibilul pentru avioane nu arde suficient de fierbinte pentru a topi oțelul, chatbot-ul ar putea contracara cu, de exemplu, Raport NIST arătând că oțelul își pierde rezistența la temperaturi mult mai scăzute, suficient pentru a slăbi structurile turnurilor astfel încât să se prăbușească. Cineva care a crezut că 11 septembrie a fost o muncă internă și a citat demolările ca dovezi ar primi un răspuns diferit, adaptat la asta.

Participanții au răspuns apoi la același set de întrebări după dialogurile lor cu chatbot, care au durat în medie aproximativ opt minute. Costello et al. a constatat că aceste dialoguri direcționate au dus la o scădere cu 20% a convingerilor dezinformate ale participanților – o reducere care a persistat chiar și două luni mai târziu, când participanții au fost evaluați din nou.

După cum au remarcat Bence Bago (Universitatea Tilburg) și Jean-Francois Bonnefon (CNRS, Toulouse, Franța) în o perspectivă însoțitoareacesta este un efect substanțial în comparație cu scăderea cu 1 până la 6 la sută a convingerilor atinsă de alte intervenții. Ei au considerat, de asemenea, persistența efectului demn de remarcat, avertizând în același timp că două luni sunt „insuficiente pentru a elimina complet convingerile de conspirație dezinformate”.